![]() 前沿资讯

1741244895更新

前沿资讯

1741244895更新

![]() 0

0

前谷歌首席执行官埃里克·施密特、Scale AI首席执行官亚历山大·王以及美国人工智能安全中心主任丹·亨德里克斯联合发布政策文件《超级智能战略》,明确反对美国推行“曼哈顿计划”式通用人工智能(AGI)开发项目。

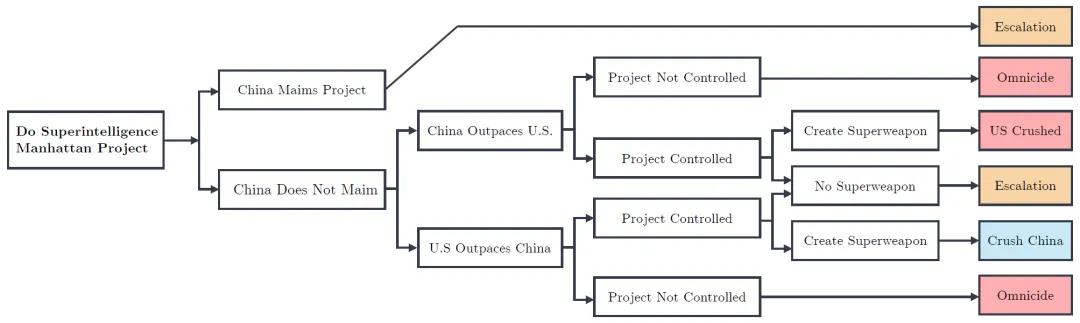

此前,美国国会委员会提议开展“曼哈顿计划”式行动,为AGI开发提供资金,美国能源部长也宣称美国正处于人工智能领域“新曼哈顿计划的开端”。然而,施密特等人在文件中指出,美国若积极寻求独家控制超级智能AI系统,可能会引发他国的强烈报复,如网络攻击等,进而破坏国际关系稳定。为此,施密特等人建议美国转变战略重点,从“赢得超级智能竞赛”转向开发阻止他国创建超级智能的方法。

《超级智能战略》中表示,AI的快速进步给社会带来了巨大改变,其两用性使其在军事和民用领域均有广泛应用,然而,这也带来了诸多风险。一方面,AI降低了大规模破坏行为的门槛,个体借助AI病毒学家或黑客工具,便能造成巨大危害,而国防在生物和关键基础设施防御方面常滞后于攻击,使得社会面临更大风险。另一方面,各国在AI军事应用上的竞争,可能打破现有力量平衡,甚至颠覆核威慑。同时,AI系统若能自主研发下一代AI,还可能引发“智能爆炸”,导致人类难以掌控局面。

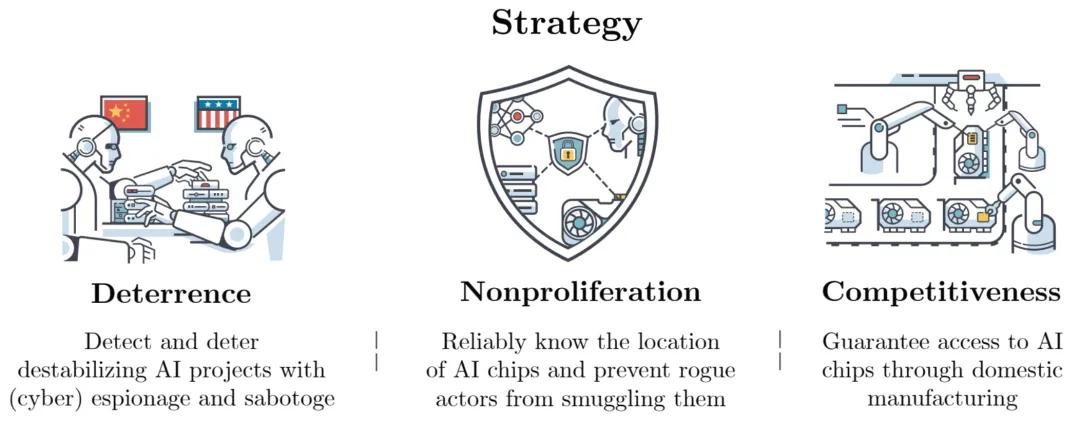

面对这些严峻挑战,现有的一些应对策略存在明显缺陷。“放任不管”策略主张对AI开发不加限制,这无疑增加了恶意使用的风险;“暂停开发”策略虽呼吁在AI达到危险阈值时自愿暂停,但缺乏有效核查机制,难以实现;“垄断开发”策略设想由单一项目垄断先进AI开发,却可能引发敌对反应,加剧紧张局势。为此,报告提出了以威慑、竞争力和防扩散为核心的超级智能战略。

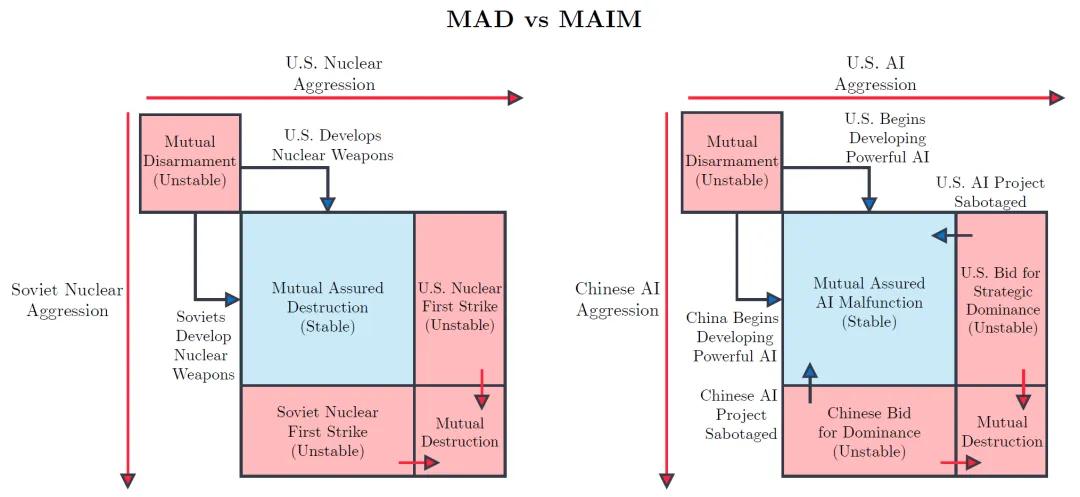

威慑:引入“相互确保AI故障”(MAIM)概念,借鉴核威慑“相互确保摧毁”(MAD)的模式,当一国意识到对手的AI项目威胁自身安全时,会采取预防性破坏行动。这种威慑机制已在AI领域初见雏形,因为破坏一个不稳定的AI项目相对容易,从间谍活动获取情报,到网络攻击干扰训练,甚至在极端情况下进行实体打击,都能对威胁项目造成影响。为维持MAIM机制的稳定,各国需明确攻击的升级阶梯,避免误判,同时扩大针对AI项目的网络攻击手段,将数据中心建在偏远地区,区分危险和可接受的AI项目,并借助AI辅助检查提高透明度。

竞争力:在经济层面,AI芯片成为经济实力的关键因素,各国应投资建设本国的AI芯片制造设施,减少对外部供应链的依赖,以应对潜在的供应中断风险。在军事层面,各国要确保无人机供应链的安全,将AI合理融入指挥控制和网络攻击中,同时保持人类对关键军事决策的监督,避免因AI失误引发“闪击战”。

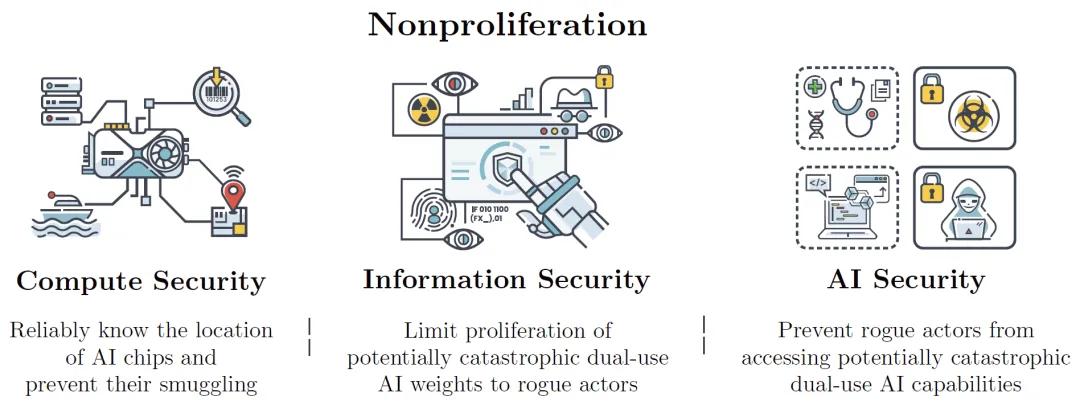

防扩散:鉴于AI落入不法分子手中可能造成的巨大危害,各国需从计算安全、信息安全和AI安全三个方面构建防线。计算安全旨在限制高端AI芯片流入非法渠道,可通过出口管制和加强执法来实现;信息安全着重保护模型权重,防止其被恶意获取;AI安全则为AI系统设置防护措施,防止其被用于恶意目的。

当前,人工智能政策领域存在两种极端态度。“悲观论者”认为AI发展必然带来灾难性后果,主张减缓发展进程;“鸵鸟心态者”则认为应加速发展,寄希望于一切顺利。施密特等人提出了第三种方案,即采取谨慎的AGI发展方式,优先考虑防御策略。

值得一提的是,施密特此前曾积极主张美国在开发先进AI系统方面与他国激烈竞争。此次其观点转变,表明美国在AI发展战略上正面临新的思考与调整。在全球AI竞争日益激烈的背景下,未来美国将如何权衡AI发展战略,有待进一步观察。

参考资料:

https://drive.google.com/file/d/1JVPc3ObMP1L2a53T5LA1xxKXM6DAwEiC/view

https://techcrunch.com/2025/03/05/eric-schmidt-argues-against-a-manhattan-project-for-agi/

豫公网安备41010702003375号

豫公网安备41010702003375号