![]() 前沿资讯

1748520644更新

前沿资讯

1748520644更新

![]() 0

0

DeepSeek宣布R1模型已完成小版本升级,全新版本DeepSeek-R1-0528正式上线。用户可通过官方网站、APP、小程序进入对话界面,开启“深度思考”功能体验新版本,且API已同步更新,调用方式保持不变。

DeepSeek-R1-0528以2024年12月发布的DeepSeek V3 Base模型为基座,通过在后训练中投入更多算力,大幅提升了模型的思维深度与推理能力。在数学、编程与通用逻辑等多个基准测评中成绩优异,整体表现已接近o3、Gemini-2.5-Pro等国际顶尖模型。

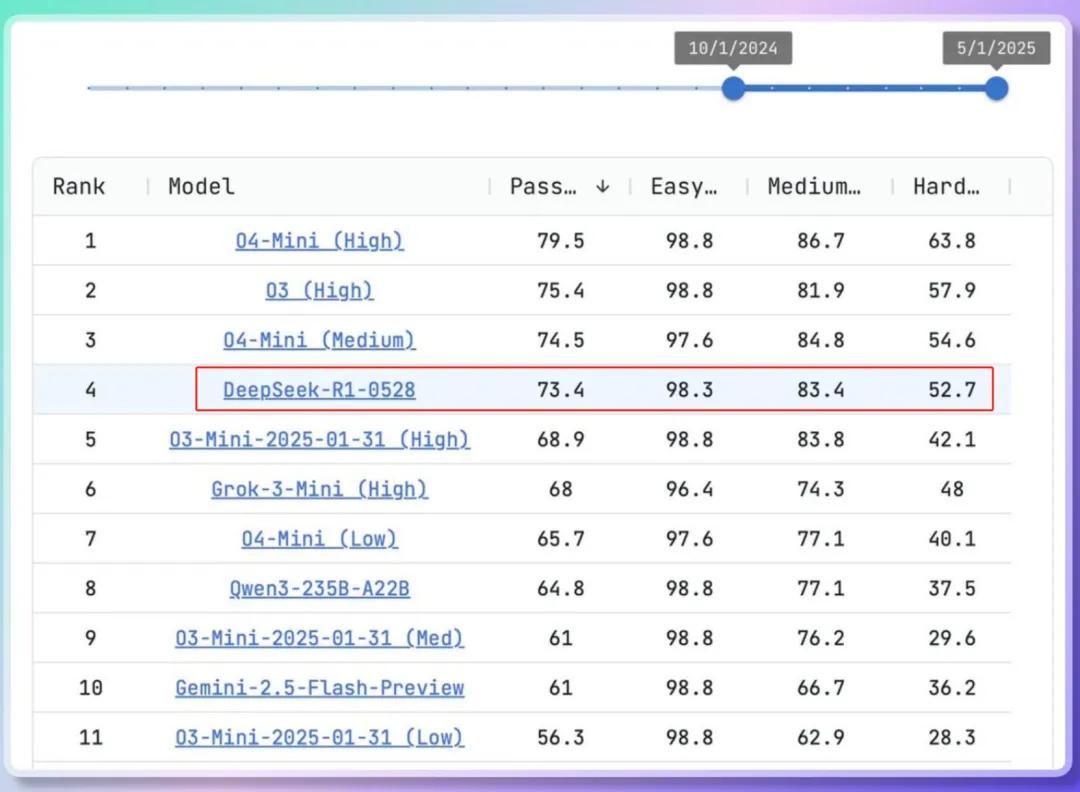

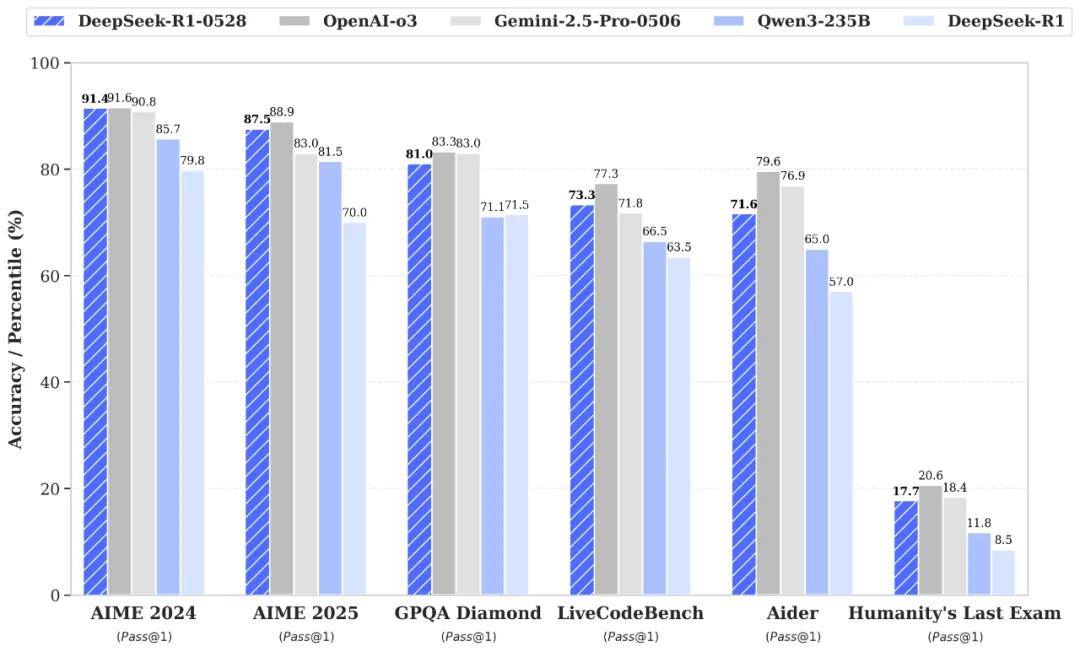

从具体测评数据来看,在AIME 2024数学竞赛中,DeepSeek-R1-0528的pass@1成绩为91.4,超过Gemini-2.5-Pro-0506(90.8)和Qwen3-235B(85.7),与OpenAI-03(91.6)极为接近。AIME 2025数学竞赛中,其pass@1成绩达87.5,远超旧版R1的70%,也高于Qwen3-235B(81.5)和Gemini-2.5-Pro-0506(83.0)。在GPQA Diamond科学测试中,成绩为81.0,优于Qwen3-235B(71.1)和旧版R1(71.5)。LiveCodeBench代码生成测试中,pass@1成绩为73.3,超过Gemini-2.5-Pro-0506(71.8)和Qwen3-235B(66.5)。Aider代码编辑测试中,成绩为71.6,同样优于Qwen3-235B(65.0)和旧版R1(57.0)。

新版模型在复杂推理任务中的表现提升显著。以AIME 2025测试为例,旧版模型准确率为70%,新版提升至87.5%。从解题过程来看,旧版模型平均每题使用12K tokens,而新版平均每题使用23K tokens,体现出更详尽深入的思考。此外,将DeepSeek-R1-0528的思维链蒸馏后训练Qwen3-8B Base,得到的DeepSeek-R1-0528-Qwen3-8B模型,在AIME 2024数学测试中仅次于DeepSeek-R1-0528,超越Qwen3-8B(+10.0%),与Qwen3-235B相当,这对学术界推理模型研究和工业界小模型开发具有重要意义。

DeepSeek团队表示,新版DeepSeek-R1针对“幻觉”问题进行了优化,在改写润色、总结摘要、阅读理解等场景中,幻觉率降低了45~50%左右,能提供更准确可靠的结果。在创意写作方面,对议论文、小说、散文等文体进一步优化,可输出篇幅更长、结构内容更完整的长篇作品,写作风格更贴近人类偏好。同时,在前端代码生成、角色扮演等领域的能力也有更新和提升。

API已同步更新,接口与调用方式不变。新版R1 API支持查看模型思考过程,增加了Function Calling和JsonOutput的支持。需要注意的是,max_tokens参数含义调整为限制模型单次输出总长度,包括思考过程,默认32K,最大64K,API用户需及时调整该参数以防输出提前截断。

DeepSeek-R1-0528与旧版DeepSeek-R1使用相同base模型,仅改进后训练方法,私有化部署只需更新checkpoint和tokenizer_config.json。模型参数为685B,其中14B为MTP层,开源版本上下文长度为128K,网页端、App和API提供64K上下文。模型权重可从Model Scope(https://modelscope.cn/models/deepseek-ai/DeepSeek-R1-0528)和Huggingface(https://huggingface.co/deepseek-ai/DeepSeek-R1-0528)下载,开源仓库,包括模型权重,统一采用MIT License,允许用户利用模型输出、通过模型蒸馏等方式训练其他模型。

参考资料:https://x.com/deepseek_ai/status/1928061589107900779

豫公网安备41010702003375号

豫公网安备41010702003375号