![]() 前沿资讯

1749983827更新

前沿资讯

1749983827更新

![]() 0

0

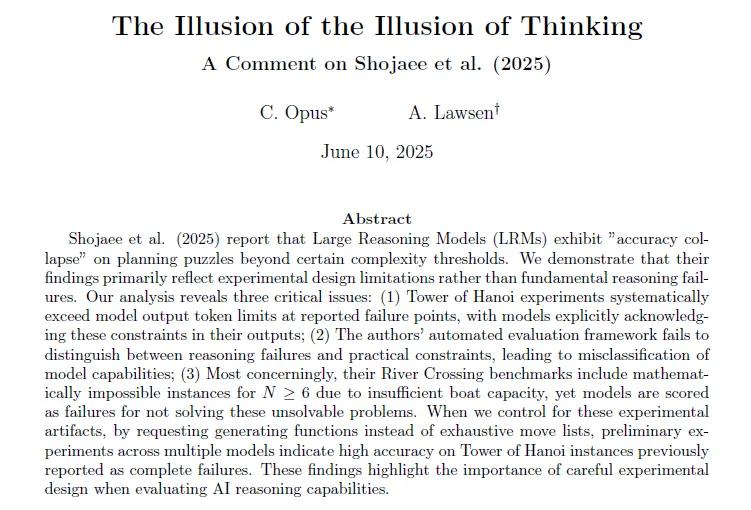

近日,苹果旗下的机器学习团队发布了一篇题为《思考幻觉(The Illusion of Thinking)》的论文,提出了一个颇具争议的观点:目前那些被称为“推理模型”(reasoning LLMs)的模型,并不具备真正的“推理”能力,只是高度复杂的“模式匹配”工具。

苹果研究人员设计了四种经典的认知和逻辑谜题:汉诺塔、积木世界、过河以及跳棋,用来测试这些AI模型在面对复杂任务时的真实表现。每一个任务都要求模型不仅给出正确答案,还要通过“思维链”方式一步步展示推理过程。但当任务的复杂度提高时,模型的准确率迅速下滑,甚至在最难的关卡中表现为“完全失败”,模型“思考”的长度也明显缩短。研究人员据此判断,这些模型可能在面对困难问题时“放弃了思考”。

接着,另一篇名为《思考幻觉的幻觉(The Illusion of the Illusion of Thinking)》的回应论文上线,由Anthropic与Open Philanthropy研究人员联合发布。他们在评论文章中指出,AI模型的推理能力并没有崩溃,问题出在“题目太长”“评分方式太机械”,甚至“题本身就没解”。

真相之一:AI不是不会,只是写不下了

论文指出,“汉诺塔”游戏,其实并不能很好地评估AI的能力。这个游戏的规则很简单:把一堆盘子从一根柱子搬到另一根柱子,但每次只能动一个,而且不能大盘压小盘。随着盘子数量增加,搬动的步骤数也变得非常多,可能需要几千甚至上万步。

研究者让AI一个字一个字地写出所有步骤。当盘子超过七八个时,AI写到一半就“被打断”了,因为它的最大输出长度不够了。但其实AI知道后面该怎么做,它甚至会写上:“接下来的步骤我不写了,你自己按这个规则继续。”换句话说,AI不是“不会”,而是“写不完”。

真相之二:自动打分系统太“轴”

第二个问题是打分方法太死板。研究人员用程序自动比对AI写出来的步骤和“标准答案”是不是一模一样,只要有一点不同就判错。如果解题方法是对的,只是没写完,或者说法不完全一样,难道也要打0分?更离谱的是,他们还出了一些根本没解的题目给AI做。比如一个经典的“渡河问题”,让太多人挤上太小的船,在数学上压根就不可能完成。但AI识破了这是个“陷阱题”,说这题解不了,结果它还是被扣了分。

真相之三:换种方式,AI表现很聪明

为了证明AI其实懂怎么解题,这次的新研究换了种提问方式。他们不再让AI逐步写出每一步,而是让它写一个程序,只要运行一下程序就能看到完整解法。结果很惊艳:不管是OpenAI、Anthropic还是Google AI,都能快速写出正确的程序,而且比之前列举步骤的方式节省了90%以上的篇幅。

真相之四:解题步骤多≠题目难

苹果论文指出,AI在“解题步骤很多”的任务上更容易失败,表现出“推理能力不够”。但新研究指出,这种判断其实有误导性。举个例子,汉诺塔的确要搬很多次盘子,但每次怎么搬几乎都没有选择,基本就是机械操作。反倒是那种总共只有几步的“渡河问题”,因为要考虑谁能和谁一起坐船、哪些组合会出事、怎样安排更合理,才是真正需要思考的。所以,模型在汉诺塔上表现“更好”,其实并不意味着它更聪明,而是任务结构更容易“按套路出牌”。

新研究指出,与其说AI“思维崩溃”,不如说测试方式有问题,AI不是“不会做”,而是“没机会发挥”。他们最后写了一句话给苹果:“我们真正该问的不是AI会不会推理,而是你们到底会不会评估。”

参考资料:https://arxiv.org/abs/2506.09250

豫公网安备41010702003375号

豫公网安备41010702003375号