![]() 前沿资讯

1760436508更新

前沿资讯

1760436508更新

![]() 0

0

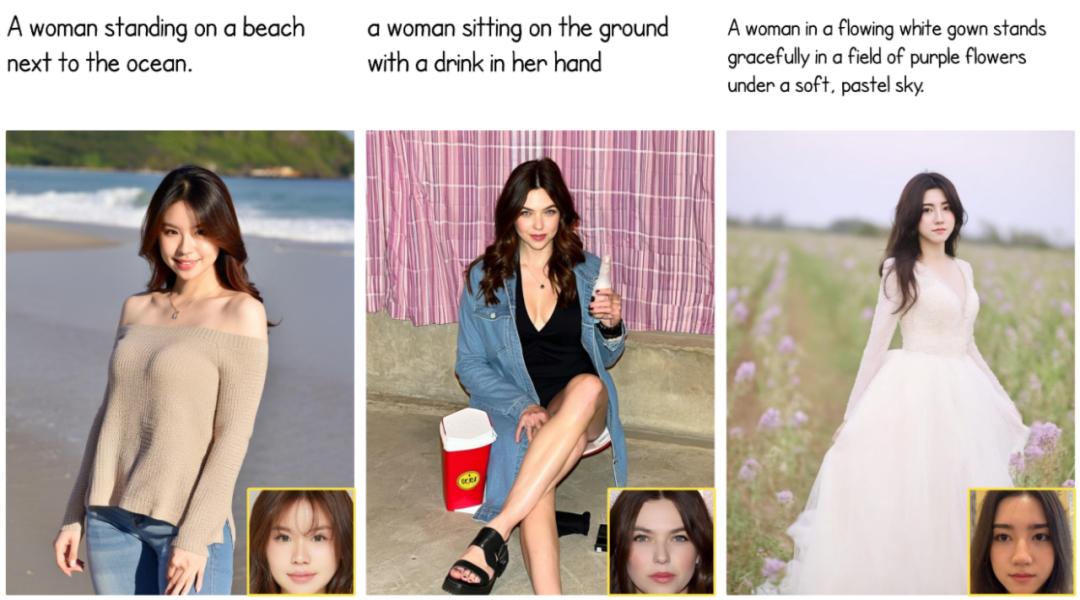

导读:字节跳动在 Hugging Face 上开源了一个全新的人脸生成框架:FaceCLIP。它专注于“让AI懂人脸”,能在保持人物身份特征的同时,根据文字描述生成多样化的人像。

在过去两年,文生图技术突飞猛进,生成的图片越来越精致,但一个老问题始终没解决好:如何在改变表情、光线或造型时,仍保留原本的面孔特征。很多模型在换角度或加特效时,人像就会“变脸”,难以维持真实感。

字节跳动的研究团队试图从根本上改进这一点。他们提出了一个新的思路:与其在原有模型上“外挂”额外模块,不如直接让AI同时理解文字与人脸信息。 于是,FaceCLIP诞生了。

它通过一个统一的多模态编码框架,将面部特征与文字语义融合在同一个嵌入空间。简单来说,FaceCLIP可以同时理解“这是谁”以及“他/她要呈现成什么样”。当用户提供一张参考人脸和一句文字描述,比如“微笑着站在落日下”,FaceCLIP就能引导生成器在保持人物身份不变的前提下,创造出符合提示的图像。

在训练过程中,FaceCLIP采用了一种“多模态对齐损失(multi-modal alignment loss)”机制,让AI在脸部特征、文字语义与最终图像三者之间建立稳定的对应关系。研究团队随后将它整合进UNet和Diffusion Transformer(DiT)架构中,形成完整的生成管线:FaceCLIP-x。

从实验结果来看,FaceCLIP-x在保留人脸身份一致性和匹配文字提示两方面都明显优于以往的同类方法,生成的人像更加真实自然。

研究人员或开发者可以直接从 GitHub 仓库获取代码,按照官方指引在本地进行推理与测试。

FaceCLIP目前包含两个主要版本:

FaceCLIP-SDXL:基于 SDXL 框架,结合 FaceCLIP-L-14 与 FaceCLIP-bigG-14 编码器进行训练;

FaceT5-FLUX:则构建在 FLUX.1-dev 模型之上,采用 FaceT5 编码器。

GitHub 仓库:https://github.com/bytedance/FaceCLIP

Hugging Face链接:https://huggingface.co/ByteDance/FaceCLIP

参考资料:https://x.com/HuggingPapers/status/1977812522398060716

豫公网安备41010702003375号

豫公网安备41010702003375号