![]() 前沿资讯

1761988825更新

前沿资讯

1761988825更新

![]() 2

2

导读:美团龙猫(LongCat)团队推出了全新开源多模态模型 LongCat-Flash-Omni,支持文本、图像、音频、视频的实时交互,并能实现毫秒级语音响应。核心亮点包括:跨模态理解能力强、长上下文记忆、低延迟实时语音交互,现在开发者和普通用户都可以体验。

美团龙猫团队推出了 LongCat-Flash-Omni,一款开放源代码的全模态(omni-modal)模型。该模型拥有 5600亿参数,其中27亿为激活参数,可以同时处理文本、图像、音频和视频输入,并生成文本或语音输出,实现真正意义上的跨模态互动。

低延迟实时交互是亮点。LongCat-Flash-Omni 支持 毫秒级端到端语音响应,最长可处理 128K token 的上下文,让多轮对话和长时记忆成为可能。无论是会议记录、音视频内容理解,还是实时语音问答,都能流畅运行。

模型采用了 ScMoE(Shortcut-connected Mixture-of-Experts)架构 和 早期融合训练(Early-Fusion Omni-modal)策略,确保在融合多模态数据时,不会牺牲单模态性能。同时,通过优化的 模态解耦并行训练方案,模型在多模态训练下仍能保持 超过90%的文本训练效率。

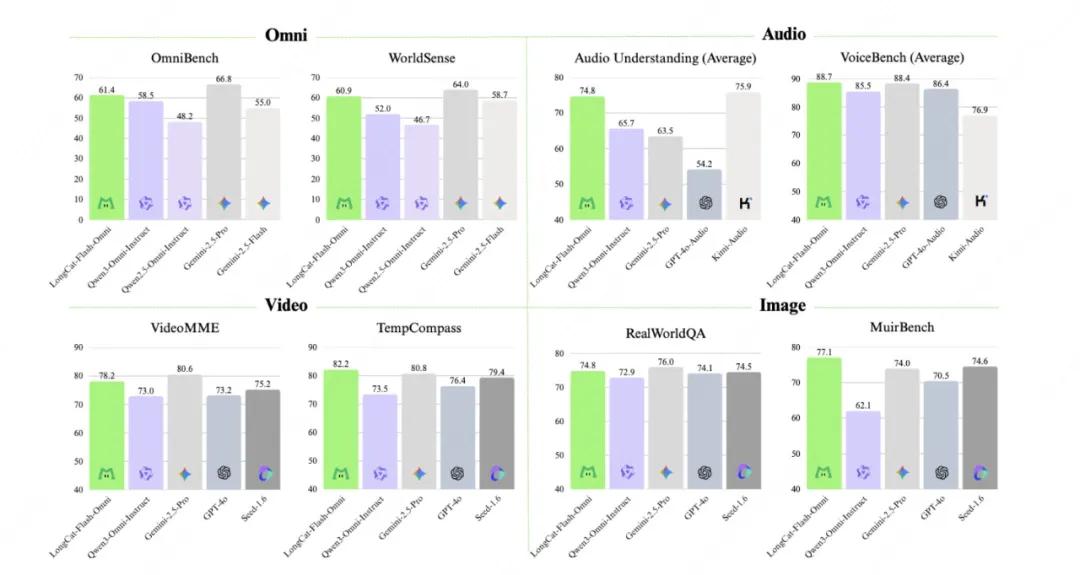

在测试中,LongCat-Flash-Omni 在多模态理解方面表现出色:

- OmniBench:61.38

- WorldSense:60.89

- DailyOmni:82.38 这些成绩显示,它在处理日常任务和多模态信息时,都有不俗表现。

为了让更多开发者参与研究,美团团队 开源了模型,并提供了详细的训练方法和数据策略。开发者可以通过 Hugging Face 或 GitHub 下载模型,同时支持 PC 和移动端体验。Hugging Face 链接:https://huggingface.co/meituan-longcat/LongCat-Flash-Omni#model-introduction

GitHub链接:https://github.com/meituan-longcat/LongCat-Flash-Omni

LongCat APP 已上线 iOS 和 Android,扫码即可体验实时语音交互功能。

参考资料:https://x.com/Meituan_LongCat/status/1984398560973242733

豫公网安备41010702003375号

豫公网安备41010702003375号