北京智源研究院发布Emu3.5:原生多模态AI迈向“世界感知”新阶段

![]() 前沿资讯

1761991445更新

前沿资讯

1761991445更新

![]() 0

0

导读:最新多模态世界模型Emu3.5正式亮相,它能同时理解图像和文字,预测未来视觉-语言状态。重点看点:超10万亿级多模态数据训练、强化学习提升推理能力、推理速度提升20倍、在图像生成和编辑上超越同类模型。

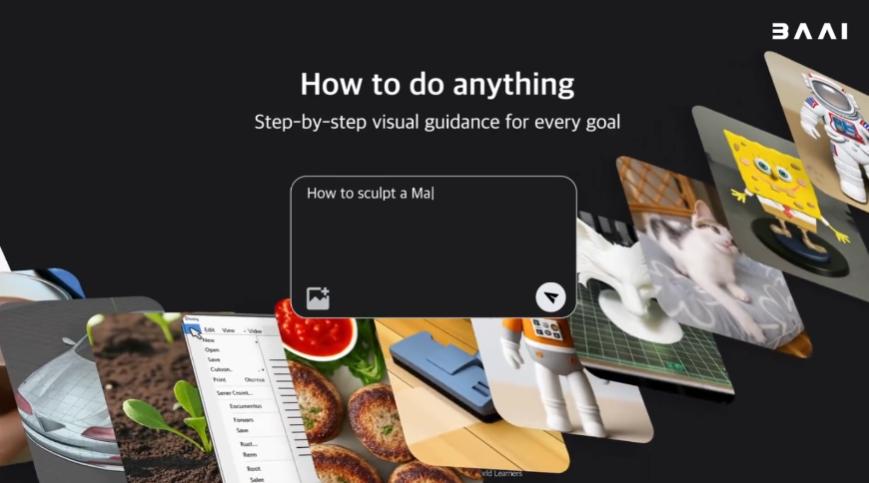

北京智源研究院(BAAI)发布了全新多模态世界模型:Emu3.5,其核心能力是原生同时处理图像与文字,能够预测未来视觉-语言状态,从而实现更连贯的世界建模和生成。

与传统模型不同,Emu3.5采用统的“下一状态预测”训练方式,直接对视频帧和文本交织序列进行学习,累计训练数据超过10万亿条多模态token。这样的训练让模型具备了出色的时空理解能力,也让它在长序列生成、图像编辑和图文混合任务中表现出色。

为了提升推理效率,Emu3.5引入了离散扩散适配(Discrete Diffusion Adaptation, DiDA)技术,将顺序解码改为双向并行预测,实现了约20倍推理速度提升,且不会损失生成质量。此外,开发团队还通过大规模强化学习后训练进一步增强了模型的推理能力、组合能力和生成表现。

在性能测试中,Emu3.5在图像生成和编辑任务中与Gemini 2.5 Flash Image(Nano Banana)持平,并在交叉生成任务中取得领先。

模型还支持任意图像生成(X2I)、文本丰富的图像创作,以及开放世界的时空一致探索与操作。

目前,Emu3.5及其高质量图像版本Emu3.5-Image已经开放权重下载和使用指南,用户可通过GitHub仓库获取,支持多GPU推理,并提供不同任务的配置示例,包括文本到图像、视觉引导和视觉叙事等。

参考资料:https://github.com/baaivision/Emu3.5

豫公网安备41010702003375号

豫公网安备41010702003375号