谷歌发布FunctionGemma:让AI能在本地“动手干活”

![]() 前沿资讯

1766214941更新

前沿资讯

1766214941更新

![]() 0

0

导读:谷歌最新推出 FunctionGemma,一款基于 Gemma 3 270M 打造的专用模型,它的目标很明确:让 AI 能在本地设备上,把自然语言直接变成可执行的系统或应用操作。

AI 的角色正在从“对话工具”转向“执行代理”。

如果只是回答问题,还不够,它还得能设置提醒、修改系统状态、调用应用接口,甚至自动完成多步操作。尤其是在本地设备上,这类能力既要反应快,又要足够稳定,还得保证隐私不出设备。

于是,FunctionGemma 出现了。

FunctionGemma 是谷歌基于 Gemma 3 270M 专门调校的一款函数调用模型。它的核心定位很清晰:把自然语言,可靠地转成可执行的 API 操作,而且能在本地跑。

它既可以作为一个完全离线、独立工作的本地代理,处理私密任务。也可以当作“流量调度员”,在本地先解决常见指令,把复杂任务再交给更大的模型,比如 Gemma 3 27B。

FunctionGemma 的几个关键特性,都在围绕“能不能真的用起来”展开:

- 统一“对话”和“行动”。FunctionGemma 既能生成结构化的函数调用,又能把执行结果再转成自然语言反馈给用户。一次模型调用,就能完成“理解 → 执行 → 解释”的完整闭环。

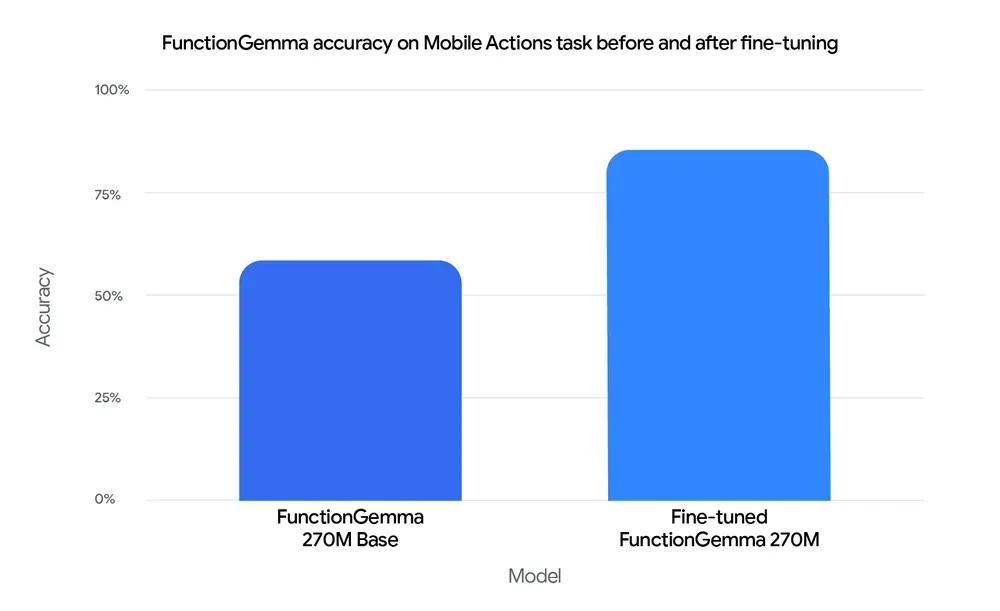

- 为微调而生,而不是只靠提示词。 在谷歌的 Mobile Actions 测试中,经过微调后,FunctionGemma 的准确率从 58% 提升到 85% 。说明在边缘设备场景下,专门训练的“小而专”的模型,比通用模型更可靠。

- 真正面向边缘设备设计。 模型体量足够小,可以运行在手机、NVIDIA Jetson Nano 等设备上。同时利用 Gemma 的 256k 词表,高效处理 JSON 和多语言输入,降低延迟、保护隐私,全程不出本地。

- 生态支持到位从 Hugging Face、Keras、NVIDIA NeMo 的训练工具,到 LiteRT-LM、vLLM、Ollama、LM Studio 等部署方案,几乎覆盖了从训练到落地的完整链路。

FunctionGemma 的发布,释放了一个非常明确的信号:AI 的重心,正在从“回答问题”,转向“执行任务”。

当模型足够小、足够专注,又能稳定地调用系统能力,AI 才真正有机会成为随身可用、可信赖的本地助手。 这一步走通之后,下一阶段的应用形态,显然会更具体,也更贴近真实使用场景。

参考资料:https://blog.google/technology/developers/functiongemma/

豫公网安备41010702003375号

豫公网安备41010702003375号