![]() 前沿资讯

1769595739更新

前沿资讯

1769595739更新

![]() 0

0

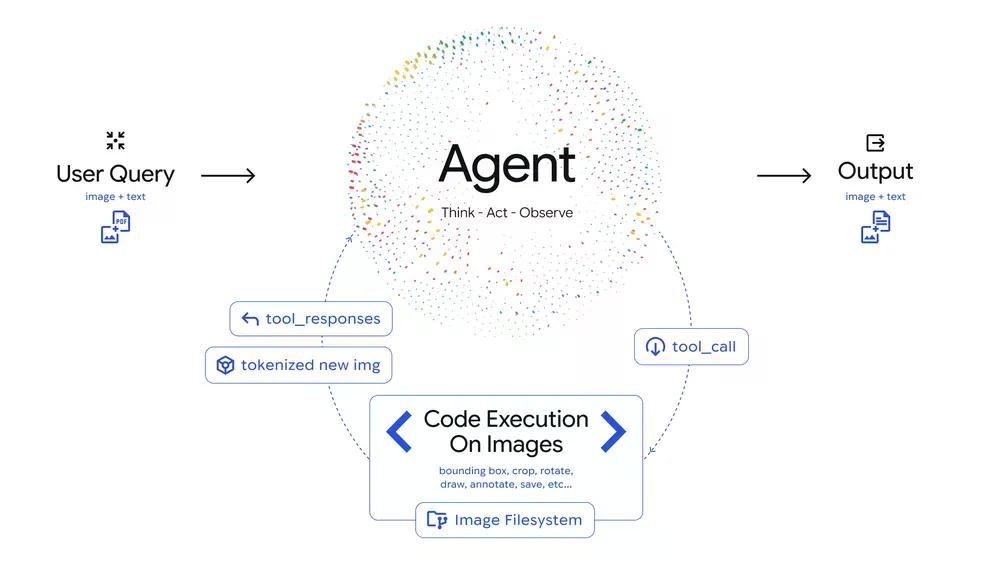

导读:传统的视觉多模态模型(LMM)本质上是“一眼定生死”,看不清就靠概率“猜”。Google 刚发布的 Agentic Vision 彻底打破了这一局限,它让 Gemini 3 Flash 具备了主动调查的能力:看图 -> 思考 -> 写 Python 代码(裁剪/旋转/标注)-> 观察新图 -> 给出结论。这种“Agent 模式”的闭环,在不增加模型规模的前提下,直接在基准测试中提升了 5-10% 的准确率。

过去,我们用多模态模型,最怕遇到分辨率极高的工业图纸或充满细小字符的电路板,模型如果第一眼没捕捉到像素点,后面全是幻觉。这种「一眼真」的模式在需要精细判断的场景下相当致命。

Agentic Vision,则把图像理解从一个静态动作变成了一个代理式(Agentic)过程。它把视觉当作一次主动的探索,通过结合视觉推理和代码执行,模型可以制定计划:放大、检查、逐步处理图像,最终让答案有据可查。

官方数据显示,启用代码执行能力的 Gemini 3 Flash 在大多数视觉基准测试中稳定提升 5-10% 的质量。这个提升幅度不算颠覆,但对工程落地来说已经很可观了。

Agentic Vision 的工作流可以拆解为三步:

- Think:模型分析用户问题和初始图像,制定一个多步骤计划

- Act:模型生成并执行 Python 代码,主动操作图像(裁剪、旋转、标注)或进行分析(计算、统计边界框数量等)

- Observe:变换后的图像被附加到模型的上下文窗口中,模型带着更好的上下文重新审视新数据,再给出最终回答

这个循环让模型不再「一眼定生死」,而是边看边想、边做边验证。

这套逻辑在工程实践中有三个最直接的应用,解决了目前 LMM 的痛点:

1. 缩放与检查。面对高分辨率建筑图纸,模型会自动识别细节模糊处并执行“局部放大”。PlanCheckSolver 的测试显示,这种迭代检查让合规性验证的准确度直接提升了5% 。

2. 图像标注。在统计手指数量或复杂零件时,模型会调用代码在图上画 Bounding Box(边界框)并打标。这种“像素级”的确认,保证了输出结论的确定性。

3. 视觉数学与绘图。面对图表,模型不再估算,而是提取原始数据并调用 Matplotlib 绘制对比图,用确定性的代码环境代替概率性的文字生成。

Google 表示这只是个开始。未来规划包括:

- 更多隐式代码驱动行为:目前缩放是自动的,但旋转、视觉数学等还需要显式提示,未来会做到全隐式

- 更多工具:正在探索接入网页搜索、反向图片搜索等工具

- 更多模型规格:Agentic Vision 未来会扩展到 Flash 之外的模型规格

Agentic Vision 现已通过 Gemini API 在 Google AI Studio 和 Vertex AI 中可用。Gemini app 也开始灰度推送(需在模型下拉菜单中选中「Thinking」模式)。

开发者可以直接在 Google AI Studio 体验 demo,或在 AI Studio Playground 中开启 Tools 下的「Code Execution」功能。官方文档有详细的 API 示例,调用方式很直接:

from google import genaifrom google.genai import typesclient = genai.Client()image = types.Part.from_uri( file_uri="https://goo.gle/instrument-img", mime_type="image/jpeg",)response = client.models.generate_content( model="gemini-3-flash-preview", contents=[image, "Zoom into the expression pedals and tell me how many pedals are there?"], config=types.GenerateContentConfig( tools=[types.Tool(code_execution=types.ToolCodeExecution)] ),)print(response.text)参考资料:https://blog.google/innovation-and-ai/technology/developers-tools/agentic-vision-gemini-3-flash/

豫公网安备41010702003375号

豫公网安备41010702003375号