![]() 前沿资讯

1770115010更新

前沿资讯

1770115010更新

![]() 0

0

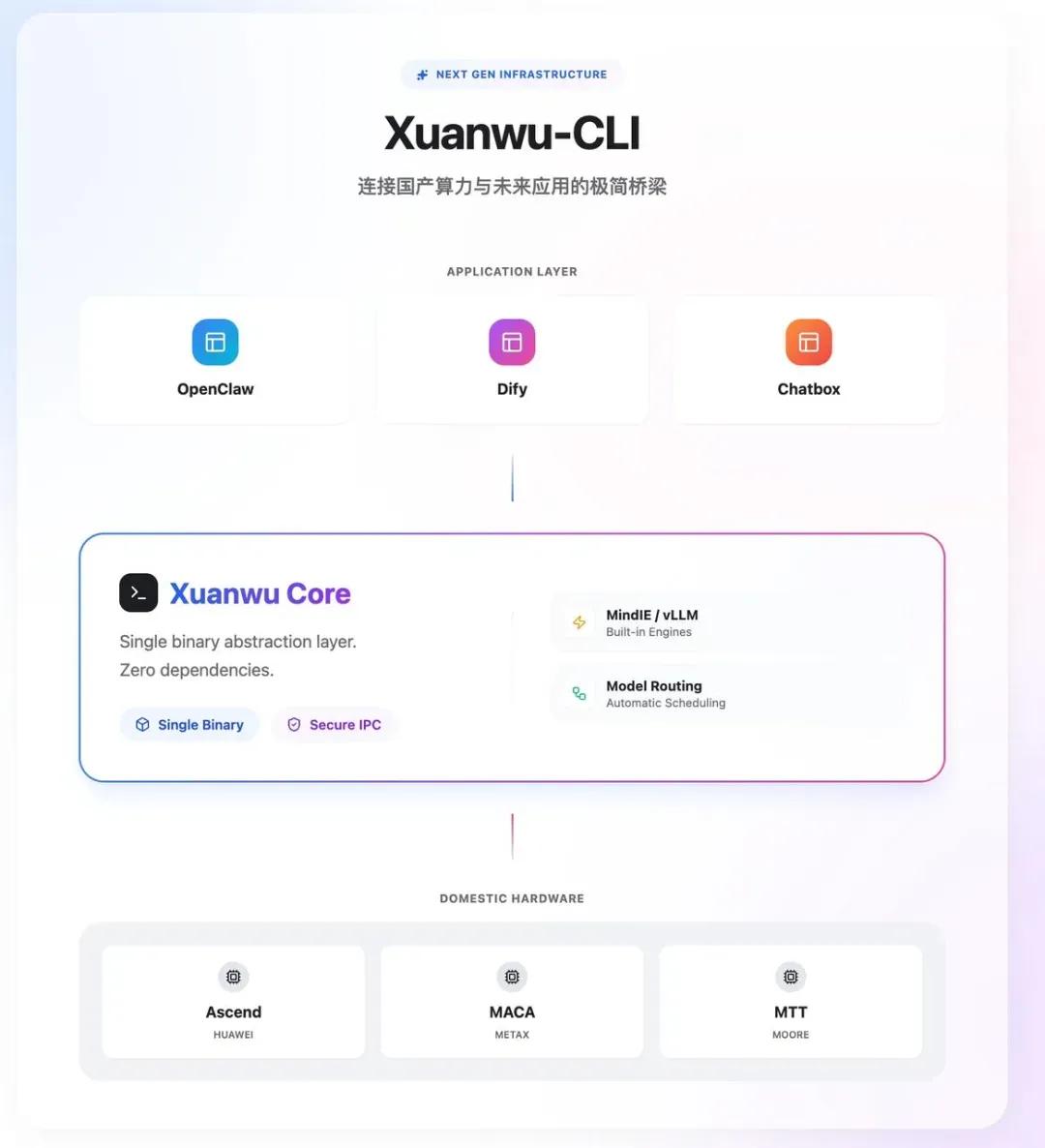

导读:清昴智能正式开源“玄武CLI”,这是一款专为国产算力打造的大模型部署工具,借鉴了Ollama的极简理念,更聚焦国产芯片生态的核心痛点:抹平架构差异、统一使用体验、实现零门槛部署。

无需复杂配置流程,5分钟即可快速启动模型服务。我们期望玄武CLI不仅能够降低企业AI部署成本,更能激活千万开发者手边国产算力潜能、加速国产AI生态落地。

当前,国产芯片在硬件性能上已具备竞争力,但软件生态的割裂与工具链的缺失,让大量国产算力陷入"能跑但不好用,能用但不省心"的困境。

开发者每更换一种国产卡,几乎就要重新学习如何构建系统。驱动、固件、Toolkit、算子包版本必须严格对齐,一个参数错误就可能导致程序崩溃。新一代模型架构如MoE、FP8量化更是缺乏成熟算子支持,推理性能大打折扣。

玄武CLI延续了极简的产品理念,真正做到解压即运行。用户无需安装Python或复杂依赖,只要基础驱动就绪,通过一行命令xw serve即可完成运行时配置初始化与端口分配,最快1分钟启动服务。

其命令体系与Ollama高度一致,开发者几乎零学习成本即可上手:

xw serve # 启动服务xw pull # 下载模型xw run #运行模型xw list #查看模型列表xw ps #查看运行状态实测数据显示,32B规模的大模型,在玄武CLI的调度下30秒内即可完成切分、显存加载与推理引擎启动,彻底告别漫长等待。

针对国产芯片架构碎片化的痛点,玄武CLI内置硬件自动识别与引擎智能匹配能力。它能精准识别华为昇腾全系列、沐曦、燧原等多款国产芯片,并根据模型特性与硬件参数,自动选择最优推理引擎与运行方案。

以往需要反复查阅文档、修改配置的繁琐流程,被玄武CLI收敛到系统内部,从根源上降低了国产芯片的使用门槛。

为兼顾极致性能与广泛兼容,玄武CLI构建了多引擎协同架构。其内置自研的核心推理引擎MLGuider,可深入芯片底层进行算子级调优,最大化释放国产硬件算力。

在应用层,玄武CLI全面兼容OpenAI API标准。基于LangChain、LlamaIndex开发的应用,或是各类IDE插件,只需修改一行API地址,即可从云端调用无缝切换到本地模型,无需重构业务逻辑。

玄武CLI开源仓库

GitHub:https://github.com/TsingmaoAI/xw-cli

Gitcode:https://gitcode.com/tsingmao/xw-cli

参考资料:https://mp.weixin.qq.com/s/uvK9GLl2HwGWV71ii_3p6A

豫公网安备41010702003375号

豫公网安备41010702003375号