![]() 前沿资讯

1727495053更新

前沿资讯

1727495053更新

![]() 0

0

大语言模型在处理各种任务时表现出了优异能力,但在复杂的逻辑推理任务上,它们的表现一致性偏移较大,并不总是令人满意。

为了克服这一挑战,来自中国科学技术大学、中国科学院自动化研究所、北京航空航天大学和京东集团的研究人员提出了一种创新的方法:逻辑注入(Logic-of-Thought,LoT),通过将逻辑规则注入到模型的推理过程中,增强其逻辑推理能力。

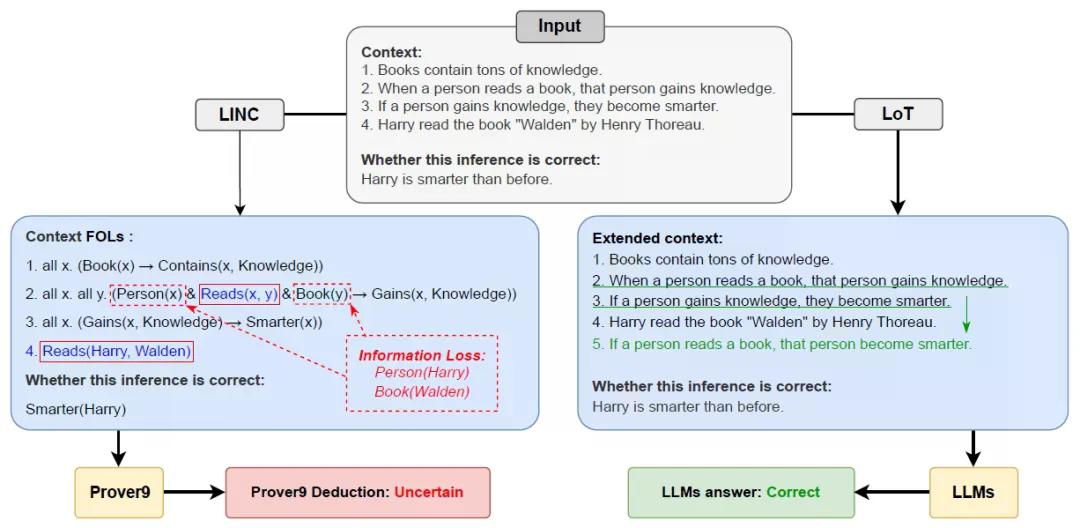

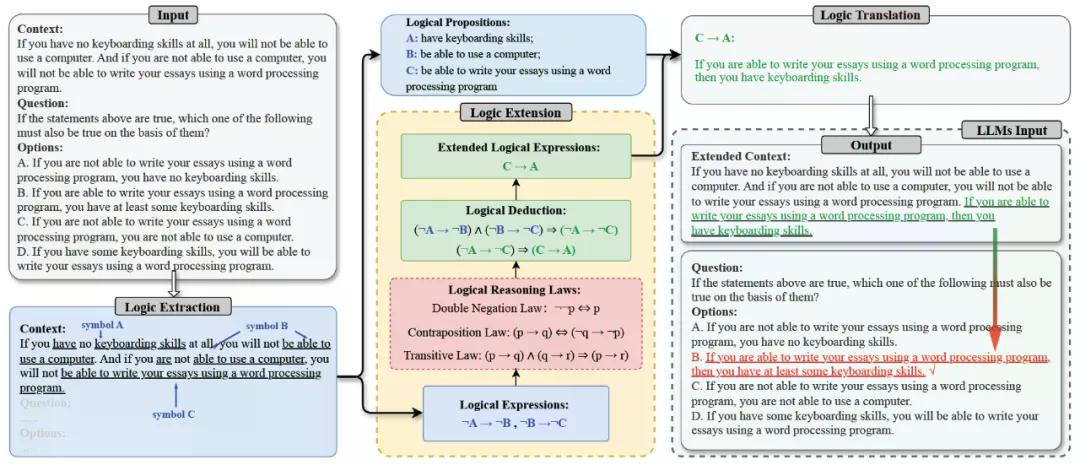

LoT方法通过三个阶段来实现这一目标:逻辑提取,逻辑扩展,最后是逻辑翻译。通过这三个阶段,LoT能够有效地将逻辑结构注入到语言模型的推理过程中,增强其处理复杂逻辑任务的能力。

逻辑提取(Logic Extraction)阶段:LoT利用语言模型的能力来识别和提取上下文中的逻辑表达式。这一阶段的目标是将自然语言描述转化为形式化的逻辑表达式,从而使模型能够更清晰地理解其中的逻辑关系。

逻辑扩展(Logic Extension)阶段:使用逻辑推理规则来扩展和细化在上一阶段提取的逻辑表达式。这一阶段可能涉及应用如反证法、传递律等逻辑定律,以生成新的逻辑表达式或进一步澄清现有表达式的含义。

逻辑翻译(Logic Translation)阶段:LoT将扩展后的逻辑表达式翻译回自然语言,形成额外的输入提示。这些翻译后的逻辑信息被集成到原始的输入提示中,指导模型进行更准确的逻辑推理。

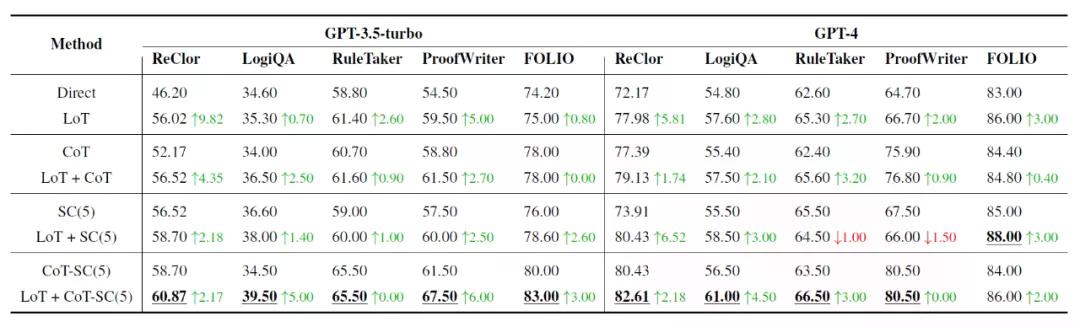

在多个逻辑推理数据集上的实验表明,LoT能够显著提升各种现有提示方法的性能,这些数据集包括ReClor、LogiQA、RuleTaker、ProofWriter和FOLIO。与现有的神经符号方法相比,LoT通过保留原始输入提示的同时,避免了信息丢失的问题,而现有的方法可能会在逻辑表达式的提取过程中丢失关键信息。

LoT的主要贡献在于提出了一种新的提示方法,它通过生成逻辑命题描述来增强原始提示。此外,LoT与多种不同的提示技术兼容,包括链式思考、自我一致性、链式思考与自我一致性的结合、思维树等,并可以无缝集成。

LoT在多个逻辑推理任务中取得了优异的性能,但它目前仅支持有限的逻辑连接词和逻辑推理规则。LoT作为一种新的符号增强提示方法,成功地解决了现有神经符号方法中固有的信息丢失问题,显著增强了LLMs的逻辑推理能力。

豫公网安备41010702003375号

豫公网安备41010702003375号